ほとんどのバッチインポートおよびエクスポートintegrationsは、より高度なデータパイプラインの一部としてworkflowsに追加できます。基本的な手順は次のとおりです:

- YAMLファイルであるworkflow定義を準備します。importインテグレーションにはtd_load> operatorを、exportインテグレーションにはtd> operatorを使用します。

- TD Consoleまたはコマンドラインインターフェースからworkflowを実行します

import integration用のSourceをすでに作成している場合は、そのユニークIDを使用してworkflow内で実行できます

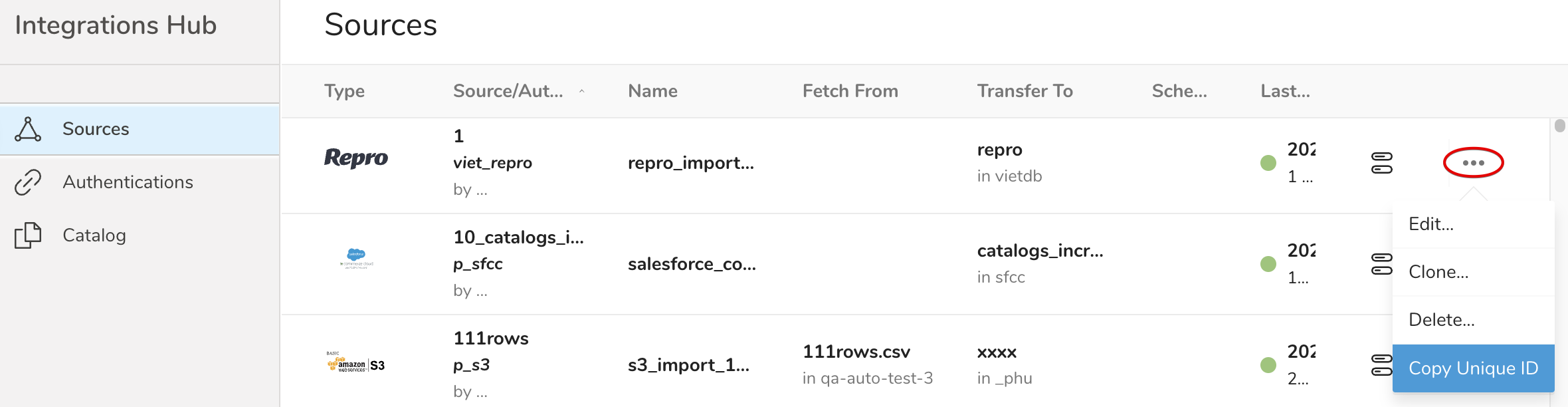

Integration HubでターゲットのSourceを特定します

...メニューを選択し、Copy Unique IDを選択します

td_load> operatorを使用してworkflowタスクを定義します。

+my_first_worklfow_step: td_load>: unique_id_of_your_source

または、import connectorのすべてのパラメータをYAMLファイルに記述し、workflow定義でそれを参照することもできます

import integration用の設定ファイル(例:load_config.yml)を準備します。例と完全なパラメータの説明は、各integrationのドキュメントに記載されています

それを参照するworkflowを定義します

+my_first_workflow_step: td_load>: config/load_config.yml database: my_database_name table: my_table_name

クエリを実行し、その結果をexport integrationにアップロードするworkflowタスクを定義する方法がいくつかあります

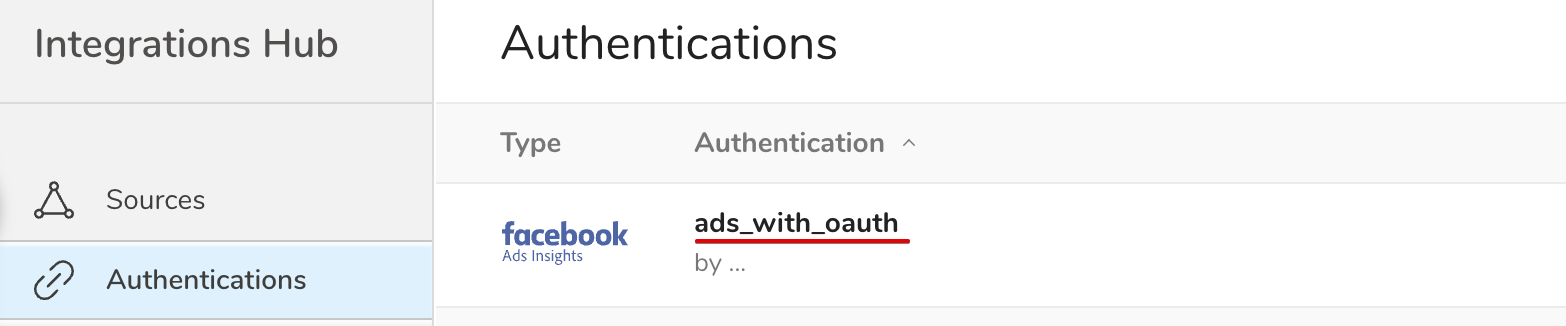

td> operatorと事前定義されたAuthenticationのnameを使用する

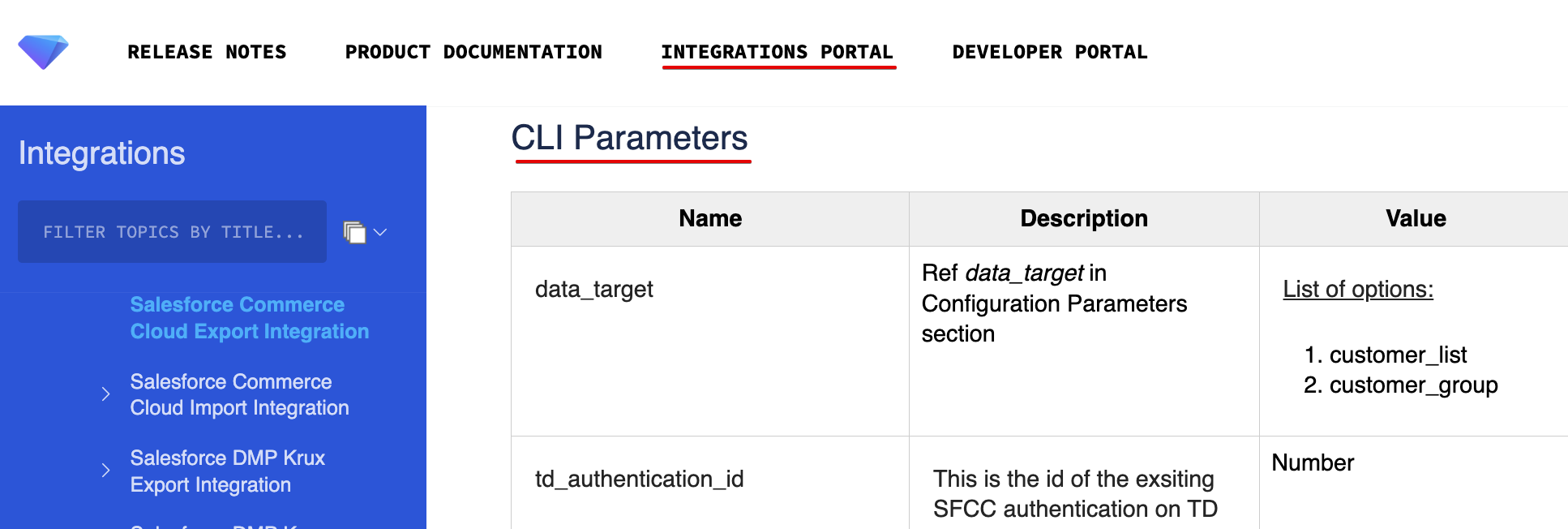

+query_and_export: td>: queries/sample.sql database: my_database result_connection: ads_with_oauth result_settings: parameter1: value1 parameter2: value2パラメータの説明は、以下のSFCC Export Integrationのように、各integrationのドキュメントに記載されています

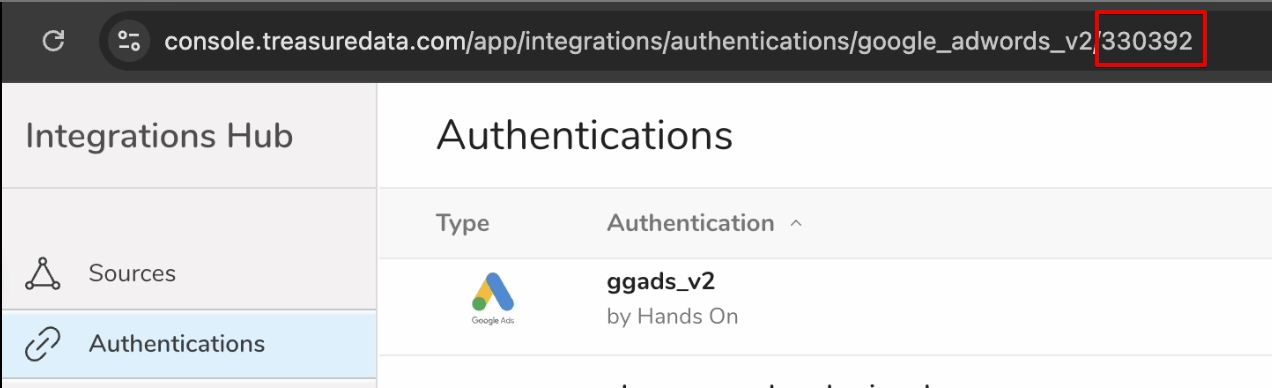

td> operatorと事前定義されたAuthenticationのIDを使用する

+query_data_and_write_result_with_existing_authentication_by_url: td>: query: 'select * from wf_test' database: my_database result_url: '{"type": "google_adwords_v2", "td_authentication_id": 330392, "bucket": "qa-auto-test-3", "path": "viet/assume_role_from_eu01.csv"}'td_run> operatorと保存済みクエリを使用する

+query_a_saved_sql: td_run>: presto_select_all_s3v2 database: my_database result_url: '{"type":"s3_v2", "td_authentication_id":260370, "bucket": "qqus-east-1", "path":"foo/wf_jan16_1444.csv"}'

workflowを定義して実行するには2つのオプションがあります

- TD Console > Data Workbench > Workflowsのグラフィカルインターフェースを使用する

- TD Toolbeltのコマンドラインインターフェースを使用する

TD Consoleを使用する方がコマンドラインインターフェースよりも簡単ですが、TD CLIツールはより複雑な設定のオプションを提供します。

TD Workflowの構文と使用方法の詳細については、こちらを参照してください